Tempo di lettura: ~ 5 min.

La proposta di direttiva sulla responsabilità da intelligenza artificiale della Commissione Europea

Alcuni dettagli in più sulla «com (2022) 496»

Alcuni dettagli in più sulla «com (2022) 496»

In tal senso, gli users danneggiati da sistemi di intelligenza artificiale potrebbero godere dello stesso livello di protezione di quelli danneggiati da altre tecnologie, alleggerendo, al contempo, l'onere della prova che nel campo dei sistemi intelligenti risulta particolarmente complesso, anche a causa del cd. effetto «black box».

Quest’ultimo incide proprio sulla trasparenza e sulla spiegabilità dell’algoritmo, ossia sulla comprensibilità di input, output e del funzionamento vero e proprio dell’AI.

In questo senso, il problema è che l’intelligenza artificiale è capace«diprodurre dei risultati, ma il processo attraverso cui produce questi risultati, la ragione per cui l’algoritmo compie specifiche decisioni, non sono totalmente comprensibili e spiegabili dal punto di vista dell’utente finale. È evidente che la trasparenza è particolarmente importante per assicurare la correttezza nell’uso degli algoritmi e per identificare possibili distorsioni»2.

La direttiva sui prodotti difettosi e la proposta AiLD

La direttiva sui prodotti difettosi e la proposta AiLD

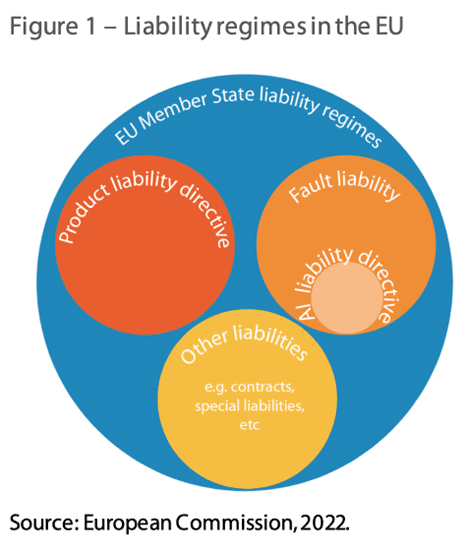

Ad oggi, per chiarezza, il quadro normativo applicabile in materia di responsabilità – su territorio europeo – è costituito dalla Direttiva 85/374/CEE (cd. «Direttiva PLD», Product Liability Directive), per i danni da prodotti difettosi, oltre che dalle norme nazionali applicabili nei singoli Stati membri.

Da un lato, dunque, le norme nazionali in materia di responsabilità offrono diverse possibilità di risarcimento per responsabilità per colpa o responsabilità oggettiva (indipendente dalla colpa).

Nel primo caso, sarà richiesta la dimostrazione dell'esistenza di un danno, di una colpa del responsabile e di un nesso di causalità tra colpa e danno, mentre nel perimetro della responsabilità oggettiva il focus verterà sulla concretizzazione del rischio derivante/generato dal responsabile, di volta in volta individuato dalla legge.

Dall’altro si pone la direttiva PLD, che ha come obiettivo quello di armonizzare a livello europeo i regimi di responsabilità oggettiva per le richieste di risarcimento dei danni causati al consumatore a causa della difettosità di una vasta gamma di prodotti (dalle materie prime ai dispositivi di intelligenza artificiale), stabilendo regole comuni in base alle quali il produttore (e in alcuni casi il fornitore/venditore) potrà essere ritenuto responsabile dei danni causati da un difetto del proprio prodotto, a condizione che la parte lesa dimostri il danno, il difetto e il nesso causale.

In base alla PLD, potrà essere richiesto un risarcimento per danni alla persona o ai beni di consumo derivanti da un prodotto difettoso fino a 10 anni dopo la messa in circolazione del prodotto stesso.

L'approccio della proposta della direttiva sulla responsabilità da IA

Diverso, invece, l’approccio della proposta di Direttiva sulla responsabilità per l'IA (di seguito per comodità anche “AiLD”), che mira ad armonizzare le norme sulla responsabilità civile extracontrattuale per i danni causati da sistemi intelligenti (IA).

L’articolo 1, infatti, recita così:

«1. La presente direttiva stabilisce norme comuni su:

(a) la divulgazione di prove relative a sistemi di intelligenza artificiale (IA) ad alto rischio per consentire a un attore di fondare una richiesta di risarcimento danni di diritto civile per colpa extracontrattuale;

b) l'onere della prova in caso di azioni civili extracontrattuali fondate su colpa intentate dinanzi ai giudici nazionali per danni causati da un sistema di IA.

2. La presente direttiva si applica alle azioni di diritto civile extracontrattuale per risarcimento danni, nei casi in cui il danno causato da un sistema di IA si verifichi dopo [la fine del periodo di recepimento].

La presente direttiva non si applica alla responsabilità penale.

3. La presente direttiva non pregiudica:

a) le norme del diritto dell'Unione che disciplinano le condizioni di responsabilità nel settore dei trasporti;

b) eventuali diritti che una persona lesa può avere ai sensi delle norme nazionali di attuazione della direttiva 85/374/CEE;

(c) le esenzioni dalla responsabilità e gli obblighi di dovuta diligenza di cui alla [legge sui servizi digitali] e

d) le norme nazionali che determinano quale parte ha l'onere della prova, quale grado di certezza è richiesto per quanto riguarda il livello della prova o come viene definita la colpa, diverse da quanto previsto dagli articoli 3 e 4.

4. Gli Stati membri possono adottare o mantenere norme nazionali più favorevoli ai ricorrenti per motivare una domanda di diritto civile extracontrattuale per danni causati da un sistema di IA, a condizione che tali norme siano compatibili con il diritto dell'Unione».

Che cos'è per «la legge» l'intelligenza artificiale?

Per garantire la coerenza, la Direttiva sulla responsabilità per l'IA fa riferimento a una serie di nozioni chiave quali «sistema di IA», «sistema di IA ad alto rischio», «fornitore» e «utente» contenute nel progetto di legge sull'IA, senza dare una definizione di tali concetti.

La AiLD, ad esempio, si rifà direttamente al concetto generale di «Sistema di IA» come previsto dall’AI Act, ossia «software developed with certain techniques and approaches (machine learning, logic- and knowledge-based approaches, statistical approaches etc.) that can, for a given set of human-defined objectives, generate outputs such as content, predictions, recommendations, or decisions influencing the environments with which these systems interact».

È giusto il caso di evidenziare come da ultimo, il Parlamento Europeo abbia accettato di adottare la definizione di AI proposta dall'Organizzazione per la Cooperazione e lo Sviluppo Economico (OCSE) nell’AI Act, segnando una svolta significativa e aprendo ai principi di omogeneità e certezza (quanto meno definitoria) a livello comunitario.

«Artificial intelligence system (ai system) means a machine-based system that is designed to operate with varying levels of autonomy and that can, for explicit or implicit objectives, generate output such as predictions, recommendations, or decisions influencing physical or virtual environments».

Le nuove norme della AiLD si applicherebbero, quindi, ai danni causati dai sistemi di IA, indipendentemente dal fatto che siano definiti ad alto rischio o meno ai sensi dell’IA act3, e a prescindere da un legame contrattuale tra “vittima” e responsabile.

Si andrebbe così a garantire che chiunque (persona fisica o giuridica) possa essere risarcito in caso di danno subito da parte di un fornitore, sviluppatore o user di IA.

3Commissione Europea, Questions & Answers: AI Liability Directive, 28 September 2022, https://ec.europa.eu/commission/presscorner/detail/en/QANDA_22_5793. Rilevante per il suo danno, e che è ragionevolmente probabile un nesso causale con la prestazione dell'IA, si potrà presumere che tale inadempienza abbia causato il danno. Ricordando, però, che: “Since this Directive introduces a rebuttable presumption, the defendant should be able to rebut it, in particular by showing that its fault could not have caused the damage” (Considerando 30).

Diversamente da altri concetti, nel caso di «richiesta di risarcimento danni» la Direttiva ne definisce la portata nel senso di richiesta di diritto civile non contrattuale, basata sulla colpa, per il risarcimento dei danni causati da un risultato di un sistema di IA o dall'incapacità di tale sistema di produrre un risultato che avrebbe dovuto essere prodotto.

Si tratta, dunque, della creazione di una presunzione di causalità che renderebbe l’onere della prova ricadente sui richiedenti il risarcimento molto più ragionevole e «semplificato».

L'articolo 4, infatti, stabilisce una presunzione di causalità confutabile che stabilisce un nesso di causalità tra l'inosservanza di un obbligo di diligenza ai sensi del diritto dell'Unione o nazionale (ossia la colpa) e l'output prodotto dal sistema di intelligenza artificiale o l'incapacità del sistema di intelligenza artificiale di produrre un output che ha dato origine al danno in questione.

In pratica, se una vittima può dimostrare che qualcuno è stato colpevole di non aver rispettato un determinato obbligo rilevante per il suo danno, e che è ragionevolmente probabile un nesso causale con la prestazione dell'IA, si potrà presumere che tale inadempienza abbia causato il danno. Ricordando, però, che: «Since this Directive introduces a rebuttable presumption, the defendant should be able to rebut it, in particular by showing that its fault could not have caused the damage» (Considerando 30).

Contenuto realizzato da Anna Capoluongo

Avvocato, DPO, Vicepresidente I.R.L.E.S.S., membro del GdL sull’intelligenza artificiale (ANORC) e di D&L Network.